通知设置 新通知

云主机IO性能测试报告

Nock 发表了文章 2 个评论 3031 次浏览 2016-12-01 18:49

吐槽云商

1、阿里云 -- 地主黑势力

阿里的包月包年捆绑式销售,创建完成后你不能及时删除释放主机,只能默默的等到期了,记得我第一次使用阿里云的时候,一口气开了10台云主机,后面我发现我不需要这么多,预算出错,但是阿里告诉我的是你人生中只有一次反悔的机会,我只能删掉一台主机。

其他的主机我只能等他默认到期了,如果实在没有多大作用我只能浪费我的银两,然后阿里坐收消费,我就当打赏王坚一个小红包了。

2、Ucloud -- 清廉百姓官

Ucloud的业务是我最喜欢的,尤其是喜欢他们的服务和UI设计。在国内做市场,我想你最应该的是调研国内技术人员的操作习惯,然后把云产品的使用达到极简、易使用,而不是黑灯找芝麻。在我的心理Ucloud是国内在云主机的操作和体验上给我的感受是最佳的。 还有就是他们的服务,他们可以一对一的帮你解决问题,耐心的解答,没有阿里那财大气粗的蛮横,不会绑架你。

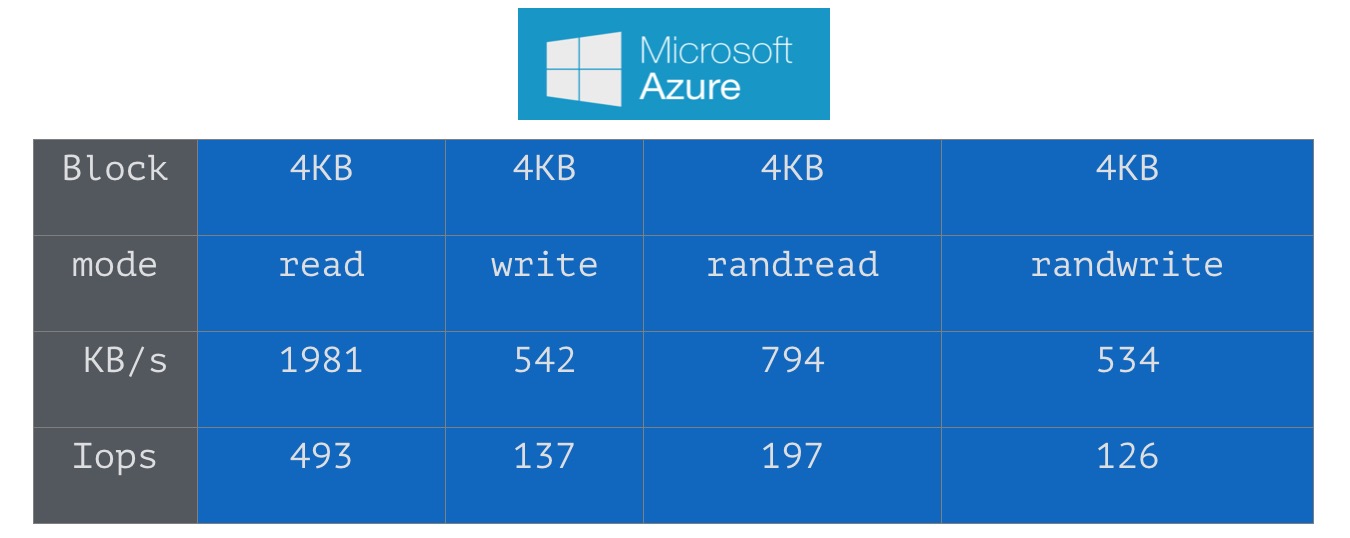

3、Azure -- 没长齐毛的鸟

为什么我说Azure是没有长齐毛的鸟,因为他的产品设计还没有完善,操作困难,可能Azure还没有大力投入做中国市场吧,好多功能都依赖于PowerShell去完成操作,比如挂盘、弹性公网ip的绑定申请等,我想说的是我是个运维,脑子里面记了一大堆命令,我使用你们产品,挂个盘你还得让我去记一大堆命令和规则,我疯了。so.......

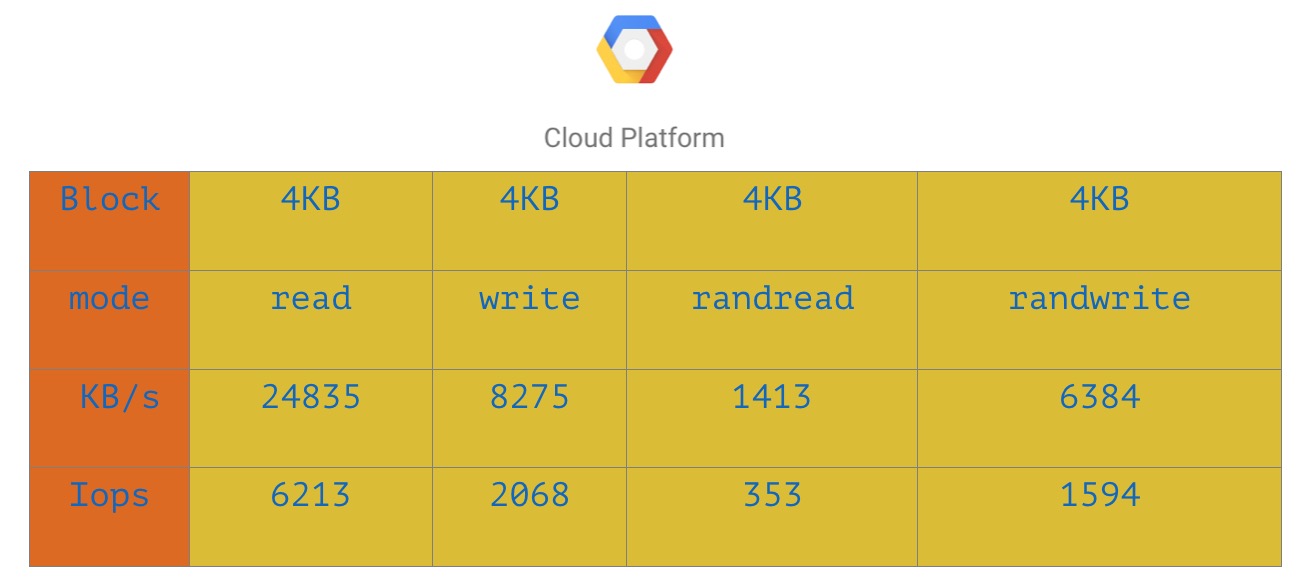

我使用过Ucloud、阿里云、Azure、Google云、AWS等诸多厂商的云产品服务,具体的其他功能我就不一一对比,下面我就介绍一下,我最近做的IO测试几家厂商的报告。

IO测试

测试命令如下:

fio -filename=/data/test.out1 -direct=1 -rw=read -bs=4k -size=10g -numjobs=4 -runtime=1200 -group_reporting -name=test1

fio -filename=/data/test.out2 -direct=1 -rw=write -bs=4k -size=10g -numjobs=4 -runtime=1200 -group_reporting -name=test2

fio -filename=/data/test.out3 -direct=1 -rw=randread -bs=4k -size=10g -numjobs=4 -runtime=1200 -group_reporting -name=test3

fio -filename=/data/test.out4 -direct=1 -rw=randwrite -bs=4k -size=10g -numjobs=4 -runtime=1200 -group_reporting -name=test4

测试结果如下:

上面分别是Ucloud、阿里、Azure、谷歌云的IO测试结果。

速率测试

测试命令如下:

dd iflag=direct /dev/null bs=16k count=102400

dd oflag=direct /data/test2 bs=16k count=102400

测试结果如下:

总结

废话不多说,以上的测试结果仅供大家参考,新时代的云运维者,必须要有语言基础了,没有语言基础,就算Ucloud的操作再怎么人性化,你也不能自动化,所以从云时代的趋势来看作为运维者掌握一门语言还是很有必要的了。云平台有很多坑,在没有充分了解厂商的情况下,你会发现云时代的运维更难。

关于Elasticsearch性能优化几个点

小白菜 发表了文章 0 个评论 5339 次浏览 2016-11-13 12:07

Elasticsearch简述

ElasticSearch是现在技术前沿的大数据引擎,常见的组合有ES+Logstash+Kibana作为一套成熟的日志系统,其中Logstash是ETL工具,Kibana是数据分析展示平台。Elasticsearch让人惊艳的是他强大的搜索相关能力和灾备策略,Elastcisearch开放了一些接口供开发者研发自己的插件,Elasticsearch结合中文分词的插件会给Elasticsearch的搜索和分析起到很大的推动作用。ElasticSearch是使用开源全文检索库Apache Lucene进行索引和搜索的,所以Elasticsearch底层是依赖的Lucene。

关于Lucene:

Apache Lucene将写入索引的所有信息组织成一种倒排索引(Inverted Index)的结构之中,该结构是种将词项映射到文档的数据结构。其工作方式与传统的关系数据库不同,大致来说倒排索引是面向词项而不是面向文档的。且Lucene索引之中还存储了很多其他的信息,如词向量等等,每个Lucene都是由多个段构成的,每个段只会被创建一次但会被查询多次,段一旦创建就不会再被修改。多个段会在段合并的阶段合并在一起,何时合并由Lucene的内在机制决定,段合并后数量会变少,但是相应的段本身会变大。段合并的过程是非常消耗I/O的,且与之同时会有些不再使用的信息被清理掉。在Lucene中,将数据转化为倒排索引,将完整串转化为可用于搜索的词项的过程叫做分析。文本分析由分析器(Analyzer)来执行,分析其由分词器(Tokenizer),过滤器(Filter)和字符映射器(Character Mapper)组成,其各个功能显而易见。除此之外,Lucene有自己的一套完整的查询语言来帮助我们进行搜索和读写。

*注:Elasticsearch中的索引指的是查询/寻址时URI中的一个字段如:[host]:[port(9200)]/[index]/[type]/[ID]?[option],而Lucene中的索引更多地和ES中的分片的概念相对应。

Elasticsearch架构设计理念特性如下:

- 合理的默认配置:只需修改节点中的Yaml配置文件,就可以快速配置。这和Spring4中对配置的简化有相似的地方。

- 分布式工作模式:Elasticsearch强大的Zen发现机制不仅支持组广播也支持点单播,且有“知一点即知天下”之妙。

- 对等架构:节点之间自动备份分片,且使分片本身和样本之间尽量”远离“,可以避免单点故障。且Master节点和Data节点几乎完全等价。

- 易于向集群扩充新节点:大大简化研发或运维将新节点加入集群所需的工作。

- 不对索引中的数据结构增加任何限制:ES支持在一个索引之中存在多种数据类型。

- 准实时:搜索和版本同步,由于ES是分布式应用,一个重大的挑战就是一致性问题,无论索引还是文档数据,然而事实证明ES表现优秀。

分片策略

选择合适的分片数和副本数:

ES的分片分为两种,主分片(Primary Shard)和副本(Replicas)。默认情况下,ES会为每个索引创建5个分片,即使是在单机环境下,这种冗余被称作过度分配(Over Allocation),目前看来这么做完全没有必要,仅在散布文档到分片和处理查询的过程中就增加了更多的复杂性,好在ES的优秀性能掩盖了这一点。假设一个索引由一个分片构成,那么当索引的大小超过单个节点的容量的时候,ES不能将索引分割成多份,因此必须在创建索引的时候就指定好需要的分片数量。此时我们所能做的就是创建一个新的索引,并在初始设定之中指定这个索引拥有更多的分片。反之如果过度分配,就增大了Lucene在合并分片查询结果时的复杂度,从而增大了耗时,所以我们得到了以下结论: 我们应该使用最少的分片!

主分片,副本和节点最大数之间数量存在以下关系:

节点数 <= 主分片数 *(副本数+1) NodeNum <= PNum * ( Rnum + 1 )这个关系,其实就是保持最好一个数据节点,最好保存一个索引的一个分片(不管主副)。

控制分片分配行为:

以上是在创建每个索引的时候需要考虑的优化方法,然而在索引已创建好的前提下,是否就是没有办法从分片的角度提高了性能了呢?当然不是,首先能做的是调整分片分配器的类型,具体是在elasticsearch.yml中设置cluster.routing.allocation.type属性,共有两种分片器even_shard,balanced(默认)。even_shard是尽量保证每个节点都具有相同数量的分片,balanced是基于可控制的权重进行分配,相对于前一个分配器,它更暴漏了一些参数而引入调整分配过程的能力。

每次ES的分片调整都是在ES上的数据分布发生了变化的时候进行的,最有代表性的就是有新的数据节点加入了集群的时候。当然调整分片的时机并不是由某个阈值触发的,ES内置十一个裁决者来决定是否触发分片调整,这里暂不赘述。另外,这些分配部署策略都是可以在运行时更新的,更多配置分片的属性也请大家自行Google。

路由优化

ES中所谓的路由和IP网络不同,是一个类似于Tag的东西。在创建文档的时候,可以通过字段为文档增加一个路由属性的Tag。ES内在机制决定了拥有相同路由属性的文档,一定会被分配到同一个分片上,无论是主分片还是副本。那么,在查询的过程中,一旦指定了感兴趣的路由属性,ES就可以直接到相应的分片所在的机器上进行搜索,而避免了复杂的分布式协同的一些工作,从而提升了ES的性能。于此同时,假设机器1上存有路由属性A的文档,机器2上存有路由属性为B的文档,那么我在查询的时候一旦指定目标路由属性为A,即使机器2故障瘫痪,对机器1构不成很大影响,所以这么做对灾况下的查询也提出了解决方案。所谓的路由,本质上是一个分桶(Bucketing)操作。当然,查询中也可以指定多个路由属性,机制大同小异。

Elasticsearch GC调优

ElasticSearch本质上是个Java程序,所以配置JVM垃圾回收器本身也是一个很有意义的工作。我们使用JVM的Xms和Xmx参数来提供指定内存大小,本质上提供的是JVM的堆空间大小,当JVM的堆空间不足的时候就会触发致命的OutOfMemoryException。这意味着要么内存不足,要么出现了内存泄露。处理GC问题,首先要确定问题的源头,一般有三种方案:

- 开启ElasticSearch上的GC日志

- 使用jstat命令

- 生成内存Dump

第一条,在ES的配置文件elasticsearch.yml中有相关的属性可以配置,关于每个属性的用途这里当然说不完。

第二条,jstat命令可以帮助我们查看JVM堆中各个区的使用情况和GC的耗时情况。

第三条,最后的办法就是将JVM的堆空间转储到文件中去,实质上是对JVM堆空间的一个快照。

想了解更多关于JVM本身GC调优方法请参考:http://www.oracle.com/technetwork/java/javase/gc-tuning-6-140523.html

另外,通过修改ES节点的启动参数,也可以调整GC的方式,但是实质上和上述方法是等同的。

避免内存交换

这一点很简单,由于操作系统的虚拟内存页交换机制,会给性能带来障碍,如数据写满内存会写入Linux中的Swap分区。

可以通过在elasticsearch.yml文件中的bootstrap.mlockall设置为true来实现,但是需要管理员权限,需要修改操作系统的相关配置文件。

控制索引合并

上文提到过,ES中的分片和副本本质上都是Lucene索引,而Lucene索引又基于多个索引段构建(至少一个),索引文件中的绝大多数都是只被写一次,读多次,在Lucene内在机制控制下,当满足某种条件的时候多个索引段会被合并到一个更大的索引段,而那些旧的索引段会被抛弃并移除磁盘,这个操作叫做段合并。

Lucene要执行段合并的理由很简单充分:索引段粒度越小,查询性能越低且耗费的内存越多。频繁的文档更改操作会导致大量的小索引段,从而导致文件句柄打开过多的问题,如修改系统配置,增大系统允许的最大文件打开数。总的来讲,当索引段由多一个合并为一个的时候,会减少索引段的数量从而提高ES性能。对于研发者来讲,我们所能做的就是选择合适的合并策略,尽管段合并完全是Lucene的任务,但随着Lucene开放更多配置借口,新版本的ES还是提供了三种合并的策略tiered,log_byte_size,log_doc。另外,ES也提供了两种Lucene索引段合并的调度器:concurrent和serial。其中各者具体区别,这里暂不赘述,只是抛砖引玉。

ElasticsearchIllegalArgumentException 错误

空心菜 回复了问题 2 人关注 1 个回复 8631 次浏览 2016-11-08 19:47

Elasticsearch的UNASSIGNED shareds怎么恢复?

空心菜 回复了问题 2 人关注 2 个回复 5872 次浏览 2016-11-08 10:54

CDH Hadoop + HBase HA 部署详解

空心菜 发表了文章 0 个评论 8232 次浏览 2016-11-07 21:07

CDH 的部署和 Apache Hadoop 的部署是没有任何区别的。这里着重的是 HA的部署,需要特殊说明的是NameNode HA 需要依赖 Zookeeper。

准备

Hosts文件配置:

cat > /etc/hosts << _HOSTS_

127.0.0.1 localhost

10.0.2.59 cdh-m1

10.0.2.60 cdh-m2

10.0.2.61 cdh-s1

_HOSTS_

各个节点服务情况

cdh-m1 Zookeeper JournalNode NameNode DFSZKFailoverController HMaster

cdh-m2 Zookeeper JournalNode NameNode DFSZKFailoverController HMaster

cdh-s1 Zookeeper JournalNode DataNode HRegionServer

对几个新服务说明下:

- JournalNode 用于同步 NameNode 元数据,和 Zookeeper 一样需要 2N+1个节点存活集群才可用;

- DFSZKFailoverController(ZKFC) 用于主备切换,类似 Keepalived 所扮演的角色。

NTP 服务

设置时区

rm -f /etc/localtime

ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

配置NTP Server

yum install -y ntp

cat > /etc/ntp.conf << _NTP_

driftfile /var/lib/ntp/drift

restrict default nomodify

restrict -6 default nomodify

server cn.ntp.org.cn prefer

server news.neu.edu.cn iburst

server dns.sjtu.edu.cn iburst

server 127.127.1.1 iburst

tinker dispersion 100

tinker step 1800

tinker stepout 3600

includefile /etc/ntp/crypto/pw

keys /etc/ntp/keys

_NTP_

# NTP启动时立即同步

cat >> /etc/ntp/step-tickers << _NTP_

server cn.ntp.org.cn prefer

server news.neu.edu.cn iburst

server dns.sjtu.edu.cn iburst

_NTP_

# 同步硬件时钟

cat >> /etc/sysconfig/ntpd << _NTPHW_

SYNC_HWCLOCK=yes

_NTPHW_

启动并设置开机自启动

/etc/init.d/ntpd start

chkconfig ntpd on

配置 NTP Client

yum install -y ntp

# 注意修改内网NTP Server地址

cat > /etc/ntp.conf << _NTP_

driftfile /var/lib/ntp/drift

restrict default nomodify

restrict -6 default nomodify

restrict 127.0.0.1

restrict -6 ::1

server 10.0.2.59 prefer

tinker dispersion 100

tinker step 1800

tinker stepout 3600

includefile /etc/ntp/crypto/pw

keys /etc/ntp/keys

_NTP_

# NTP启动时立即同步

cat >> /etc/ntp/step-tickers << _NTP_

server 10.0.2.59 prefer

_NTP_

# 同步硬件时钟

cat >> /etc/sysconfig/ntpd << _NTPHW_

SYNC_HWCLOCK=yes

_NTPHW_

启动并设置开机自启动

/etc/init.d/ntpd start

chkconfig ntpd on

检查 NTP 同步

ntpq -p

# 结果

remote refid st t when poll reach delay offset jitter

==============================================================================

*time7.aliyun.co 10.137.38.86 2 u 17 64 3 44.995 5.178 0.177

news.neu.edu.cn .INIT. 16 u - 64 0 0.000 0.000 0.000

202.120.2.90 .INIT. 16 u - 64 0 0.000 0.000 0.000

JDK配置

创建目录

mkdir -p /data/{install,app,logs,pid,appData}

mkdir /data/appData/tmp

cd /data/install

wget -c http://oracle.com/jdk-7u51-linux-x64.gz

tar xf jdk-7u51-linux-x64.gz -C /data/app

cd /data/app

ln -s jdk1.7.0_51 jdk1.7

cat >> /etc/profile << _PATH_

export JAVA_HOME=/data/app/jdk1.7

export CLASSPATH=.:\$JAVA_HOME/lib/dt.jar:\$JAVA_HOME/lib/tools.jar

export PATH=\$JAVA_HOME/bin:\$PATH

_PATH_

source /etc/profile

创建运行账户

useradd -u 600 run

下载 安装包

# http://archive.cloudera.com/cdh5/cdh/5/

cd /data/install

wget -c http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.6.0-cdh5.4.5.tar.gz

wget -c http://archive.apache.org/dist/zookeeper/zookeeper-3.4.5/zookeeper-3.4.5.tar.gz

wget -c http://archive.cloudera.com/cdh5/cdh/5/hbase-1.0.0-cdh5.4.5.tar.gz

安装 Zookeeper

cd /data/install

tar xf zookeeper-3.4.5.tar.gz -C /data/app

cd /data/app

ln -s zookeeper-3.4.5 zookeeper

设置环境变量

sed -i '/^export PATH=/i\export ZOOKEEPER_HOME=/data/app/zookeeper' /etc/profile

sed -i 's#export PATH=#&\$ZOOKEEPER_HOME/bin:#' /etc/profile

source /etc/profile

删除无用文件

cd $ZOOKEEPER_HOME

rm -rf *xml *txt zookeeper-3.4.5.jar.* src recipes docs dist-maven contrib

rm -f $ZOOKEEPER_HOME/bin/*.cmd $ZOOKEEPER_HOME/bin/*.txt

rm -f $ZOOKEEPER_HOME/conf/zoo_sample.cfg

创建数据目录

mkdir -p /data/appData/zookeeper/{data,logs}

配置

cat > $ZOOKEEPER_HOME/conf/zoo.cfg << _ZOO_

tickTime=2000

initLimit=10

syncLimit=5

clientPort=2181

dataDir=/data/appData/zookeeper/data

dataLogDir=/data/appData/zookeeper/logs

server.1=cdh-m1:2888:3888

server.2=cdh-m2:2888:3888

server.3=cdh-s1:2888:3888

_ZOO_

修改Zookeeper的日志打印方式,与日志路径设置, 编辑

$ZOOKEEPER_HOME/bin/zkEnv.sh

在27行后加入两个变量

ZOO_LOG_DIR=/data/logs/zookeeper

ZOO_LOG4J_PROP="INFO,ROLLINGFILE"

创建 myid文件

# 注意myid与配置文件保持一致

echo 1 >/data/appData/zookeeper/data/myid

设置目录权限

chown -R run.run /data/{app,appData,logs}

启动、停止

# 启动

runuser - run -c 'zkServer.sh start'

# 停止

runuser - run -c 'zkServer.sh stop'

安装 Hadoop

tar xf hadoop-2.6.0-cdh5.4.5.tar.gz -C /data/app

cd /data/app

ln -s hadoop-2.6.0-cdh5.4.5 hadoop

设置环境变量

sed -i '/^export PATH=/i\export HADOOP_HOME=/data/app/hadoop' /etc/profile

sed -i 's#export PATH=#&\$HADOOP_HOME/bin:\$HADOOP_HOME/sbin:#' /etc/profile

source /etc/profile

删除无用文件

cd $HADOOP_HOME

rm -rf *txt share/doc src examples* include bin-mapreduce1 cloudera

find . -name "*.cmd"|xargs rm -f

新建数据目录

mkdir -p /data/appData/hdfs/{name,edits,data,jn,tmp}

配置

切换到配置文件目录

cd $HADOOP_HOME/etc/hadoop

编辑 core-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- HDFS 集群名称,可指定端口 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hdfs-cdh</value>

</property>

<!-- 临时文件目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/appData/hdfs/tmp</value>

</property>

<!-- 回收站设置,0不启用回收站,1440 表示1440分钟后删除 -->

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

<!-- SequenceFiles在读写中可以使用的缓存大小,单位 bytes 默认 4096 -->

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<!-- 可用压缩算法,启用在hdfs-site.xml中,需要编译动态链接库才能用 -->

<property>

<name>io.compression.codecs</name>

<value>org.apache.hadoop.io.compress.SnappyCodec</value>

</property>

</configuration>

编辑 hdfs-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 指定hdfs 集群名称,需要和core-site.xml中的保持一致 -->

<property>

<name>dfs.nameservices</name>

<value>hdfs-cdh</value>

</property>

<!-- 指定 Zookeeper 用于NameNode HA,默认官方配置在core-site.xml中,为了查看清晰配置到hdfs-site.xml也是可用的 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>cdh-m1:2181,cdh-m2:2181,cdh-s1:2181</value>

</property>

<!-- hdfs-cdh 下有两个NameNode,分别为 nn1,nn2 -->

<property>

<name>dfs.ha.namenodes.hdfs-cdh</name>

<value>nn1,nn2</value>

</property>

<!-- nn1 RPC通信地址 -->

<property>

<name>dfs.namenode.rpc-address.hdfs-cdh.nn1</name>

<value>cdh-m1:9000</value>

</property>

<!-- nn1 HTTP通信地址 -->

<property>

<name>dfs.namenode.http-address.hdfs-cdh.nn1</name>

<value>cdh-m1:50070</value>

</property>

<!-- nn2 RPC通信地址 -->

<property>

<name>dfs.namenode.rpc-address.hdfs-cdh.nn2</name>

<value>cdh-m2:9000</value>

</property>

<!-- nn2 HTTP通信地址 -->

<property>

<name>dfs.namenode.http-address.hdfs-cdh.nn2</name>

<value>cdh-m2:50070</value>

</property>

<!-- 指定NameNode元数据在JournalNode上的存储路径 -->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://cdh-m1:8485;cdh-m2:8485;cdh-s1:8485;/hdfs-cdh</value>

</property>

<!-- 开启NameNode失败自动切换 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- 配置主备切换实现方式 -->

<property>

<name>dfs.client.failover.proxy.provider.hdfs-cdh</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!-- 配置主备切换方法,每个方法一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

<!-- 指定运行用户的秘钥,需要NameNode双向免密码登录,用于主备自动切换 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/run/.ssh/id_rsa</value>

</property>

<!-- 配置sshfence 超时时间 -->

<property>

<name>dfs.ha.fencing.ssh.connect-timeout</name>

<value>50000</value>

</property>

<!-- NameNode 数据本地存储路径 -->

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/appData/hdfs/name</value>

</property>

<!-- DataNode 数据本地存储路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/appData/hdfs/data</value>

</property>

<!-- JournalNode 数据本地存储路径 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/data/appData/hdfs/jn</value>

</property>

<!-- 修改文件存储到edits,定期同步到DataNode -->

<property>

<name>dfs.namenode.edits.noeditlogchannelflush</name>

<value>true</value>

</property>

<!-- edits 数据本地存储路径 -->

<property>

<name>dfs.namenode.edits.dir</name>

<value>/data/appData/hdfs/edits</value>

</property>

<!-- 开启Block Location metadata允许impala知道数据块在哪块磁盘上 默认关闭 -->

<property>

<name>dfs.datanode.hdfs-blocks-metadata.enabled</name>

<value>true</value>

</property>

<!-- 权限检查 默认开启 -->

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<!-- block 大小设置 -->

<property>

<name>dfs.blocksize</name>

<value>64m</value>

</property>

</configuration>

小于5个DataNode建议添加如下配置

<!-- 数据副本数量,不能超过DataNode数量,大集群建议使用默认值 默认 3 -->

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<!-- 当副本写入失败时不分配新节点,小集群适用 -->

<property>

<name>dfs.client.block.write.replace-datanode-on-failure.policy</name>

<value>NEVER</value>

</property>

在 hadoop-env.sh 中添加如下变量

export JAVA_HOME=/data/app/jdk1.7

export HADOOP_LOG_DIR=/data/logs/hadoop

export HADOOP_PID_DIR=/data/pid

# SSH端口 可选

export HADOOP_SSH_OPTS="-p 22"

Heap 设置,单位 MB

export HADOOP_HEAPSIZE=1024

权限设置

chown -R run.run /data/{app,appData,logs}

chmod 777 /data/pid

格式化

格式化只需要执行一次,格式化之前启动Zookeeper

切换用户

su - run

启动所有 JournalNode

hadoop-daemon.sh start journalnode

格式化 Zookeeper(为 ZKFC 创建znode)

hdfs zkfc -formatZK

NameNode 主节点格式化并启动

hdfs namenode -format

hadoop-daemon.sh start namenode

NameNode 备节点同步数据并启动

hdfs namenode -bootstrapStandby

hadoop-daemon.sh start namenode

启动 ZKFC

hadoop-daemon.sh start zkfc

启动 DataNode

hadoop-daemon.sh start datanode

启动与停止

切换用户

su - run

集群批量启动

需要配置运行用户ssh-key免密码登录,与$HADOOP_HOME/etc/hadoop/slaves

# 启动

start-dfs.sh

# 停止

stop-dfs.sh

单服务启动停止

启动HDFS

hadoop-daemon.sh start journalnode

hadoop-daemon.sh start namenode

hadoop-daemon.sh start zkfc

hadoop-daemon.sh start datanode

停止HDFS

hadoop-daemon.sh stop datanode

hadoop-daemon.sh stop namenode

hadoop-daemon.sh stop journalnode

hadoop-daemon.sh stop zkfc

测试

HDFS HA 测试

打开 NameNode 状态页:

http://cdh-m1:50010

http://cdh-m2:50010

在 Overview 后面能看见 active 或 standby,active 为当前 Master,停止 active 上的 NameNode,检查 standby是否为 active。

HDFS 测试

hadoop fs -mkdir /test

hadoop fs -put /etc/hosts /test

hadoop fs -ls /test

结果:

-rw-r--r-- 2 java supergroup 89 2016-06-15 10:30 /test/hosts

# 其中权限后面的列(这里的2)代表文件总数,即副本数量。

HDFS 管理命令

# 动态加载 hdfs-site.xml

hadoop dfsadmin -refreshNodes

HBase安装配置

cd /data/install

tar xf hbase-1.0.0-cdh5.4.5.tar.gz -C /data/app

cd /data/app

ln -s hbase-1.0.0-cdh5.4.5 hbase

设置环境变量

sed -i '/^export PATH=/i\export HBASE_HOME=/data/app/hbase' /etc/profile

sed -i 's#export PATH=#&\$HBASE_HOME/bin:#' /etc/profile

source /etc/profile

删除无用文件

cd $HBASE_HOME

rm -rf *.txt pom.xml src docs cloudera dev-support hbase-annotations hbase-assembly hbase-checkstyle hbase-client hbase-common hbase-examples hbase-hadoop2-compat hbase-hadoop-compat hbase-it hbase-prefix-tree hbase-protocol hbase-rest hbase-server hbase-shell hbase-testing-util hbase-thrift

find . -name "*.cmd"|xargs rm -f

配置

进入配置文件目录

cd $HBASE_HOME/conf

编辑 hbase-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- HBase 数据存储路径 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://hdfs-cdh/hbase</value>

</property>

<!-- 完全分布式模式 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- HMaster 节点 -->

<property>

<name>hbase.master</name>

<value>cdh-m1:60000,cdh-m2:60000</value>

</property>

<!-- Zookeeper 节点 -->

<property>

<name>hbase.zookeeper.quorum</name>

<value>cdh-m1:2181,cdh-m2:2181,cdh-s1:2181</value>

</property>

<!-- znode 路径,Zookeeper集群中有多个HBase集群需要设置不同znode -->

<property>

<name>zookeeper.znode.parent</name>

<value>/hbase</value>

</property>

<!-- HBase 协处理器 -->

<property>

<name>hbase.coprocessor.user.region.classes</name>

<value>org.apache.hadoop.hbase.coprocessor.AggregateImplementation</value>

</property>

</configuration>

在 hbase-env.sh 中添加如下变量

export JAVA_HOME=/data/app/jdk1.7

export HBASE_LOG_DIR=/data/logs/hbase

export HBASE_PID_DIR=/data/pid

export HBASE_MANAGES_ZK=false

# SSH 默认端口 可选

export HBASE_SSH_OPTS="-o ConnectTimeout=1 -p 36000"

Heap 设置,单位 MB

export HBASE_HEAPSIZE=1024

可选设置 regionservers 中添加所有RegionServer主机名,用于集群批量启动、停止。

启动与停止

切换用户

su - run

集群批量启动

需要配置运行用户ssh-key免密码登录,与$HBASE_HOME/conf/regionservers

# 启动

start-hbase.sh

# 停止

stop-hbase.sh

单服务启动停止

HMaster

# 启动

hbase-daemon.sh start master

# 停止

hbase-daemon.sh stop master

HRegionServer

# 启动

hbase-daemon.sh start regionserver

# 停止

hbase-daemon.sh stop regionserver

测试

HBase HA 测试

浏览器打开两个HMaster状态页:

http://cdh-m1:60010

http://cdh-m2:60010

可以在Master后面看见其中一个主机名,Backup Masters中看见另一个。

停止当前Master,刷新另一个HMaster状态页会发现Master后面已经切换,HA成功。

HBase 测试

进入hbase shell 执行:

create 'users','user_id','address','info'

list

put 'users','anton','info:age','24'

get 'users','anton'

# 最终结果

COLUMN CELL

info:age timestamp=1465972035945, value=24

1 row(s) in 0.0170 seconds

清除测试数据:

disable 'users'

drop 'users'

到这里安装就全部完成。

Zookeeper Too many connections情况

空心菜 回复了问题 2 人关注 1 个回复 13372 次浏览 2016-11-03 12:05

Elasticsearch中常用的API接口整理

小白菜 发表了文章 0 个评论 8794 次浏览 2016-10-27 18:21

Elasticsearch中常用API分类

elasticsearch中常用的API分类如下:

- 文档API: 提供对文档的增删改查操作

- 搜索API: 提供对文档进行某个字段的查询

- 索引API: 提供对索引进行操作,查看索引信息等

- 查看API: 按照更直观的形式返回数据,更适用于控制台请求展示

- 集群API: 对集群进行查看和操作的API

Index API: 创建并建立索引文档类API

PUT twitter/tweet/1{ "user" : "kimchy", "post_date" : "2009-11-15T14:12:12", "message" : "trying out Elasticsearch"}官方文档参考:Index API 。 Get API: 获取文档curl -XGET 'http://localhost:9200/twitter/tweet/1'官方文档参考:Get API 。 DELETE API: 删除文档

$ curl -XDELETE 'http://localhost:9200/twitter/tweet/1'官方文档参考:Delete API 。 UPDATE API: 更新文档

PUT test/type1/1{ "counter" : 1, "tags" : ["red"]}官方文档参考:Update API 。 Multi Get API: 一次批量获取文档curl 'localhost:9200/_mget' -d '{ "docs" : [ { "_index" : "test", "_type" : "type", "_id" : "1" }, { "_index" : "test", "_type" : "type", "_id" : "2" } ]}'官方文档参考:Multi Get API 。 Bulk API: 批量操作,批量操作中可以执行增删改查$ curl -s -XPOST localhost:9200/_bulk --data-binary "@requests"; echo{"took":7, "errors": false, "items":[{"index":{"_index":"test","_type":"type1","_id":"1","_version":1,"result":"created","forced_refresh":false}}]}官方文档参考:Bulk API 。 DELETE By Query API: 根据查询删除POST twitter/_delete_by_query{ "query": { "match": { "message": "some message" } }}官方文档参考:Delete By Query API 。 Update By Query API: 根据查询更新POST twitter/_update_by_query?conflicts=proceed官方文档参考:Update By Query API 。 Reindex API:重建索引

POST _reindex{ "source": { "index": "twitter" }, "dest": { "index": "new_twitter" }}官方文档参考:Reindex API 。 Term Vectors: 词组分析,只能针对一个文档curl -XGET 'http://localhost:9200/twitter/tweet/1/_termvectors?pretty=true'官方文档参考:Term Vectors 。 Multi termvectors API: 多个文档的词组分析

curl 'localhost:9200/_mtermvectors' -d '{ "docs": [ { "_index": "testidx", "_type": "test", "_id": "2", "term_statistics": true }, { "_index": "testidx", "_type": "test", "_id": "1", "fields": [ "text" ] } ]}'官方文档参考:Multi termvectors API 。 更多关于文档类API请参考:Document APIs 。 URI Search:url中传参搜索类API

GET twitter/tweet/_search?q=user:kimchy官方文档参考:URI Search 。 Request Body搜索接口: 搜索的条件在请求的body中

GET /twitter/tweet/_search{ "query" : { "term" : { "user" : "kimchy" } }}官方文档参考:Request Body Search 。 - 搜索模版设置接口: 可以设置搜索的模版,模版的功能是可以根据不同的传入参数,进行不同的实际搜索

- 搜索分片查询接口: 查询这个搜索会使用到哪个索引和分片

- Suggest接口: 搜索建议接口,输入一个词,根据某个字段,返回搜索建议。

- 批量搜索接口: 把批量请求放在一个文件中,批量搜索接口读取这个文件,进行搜索查询

- Count接口: 只返回符合搜索的文档个数

- 文档存在接口: 判断是否有符合搜索的文档存在

- 验证接口: 判断某个搜索请求是否合法,不合法返回错误信息

- 解释接口: 使用这个接口能返回某个文档是否符合某个查询,为什么符合等信息

- 抽出器接口: 简单来说,可以用这个接口指定某个文档符合某个搜索,事先未文档建立对应搜索

索引类API

- 创建索引接口(POST my_index)

- 删除索引接口(DELETE my_index)

- 获取索引信息接口(GET my_index)

- 索引是否存在接口(HEAD my_index)

- 打开/关闭索引接口(my_index/_close, my_index/_open)

- 设置索引映射接口(PUT my_index/_mapping)

- 获取索引映射接口(GET my_index/_mapping)

- 获取字段映射接口(GET my_index/_mapping/field/my_field)

- 类型是否存在接口(HEAD my_index/my_type)

- 删除映射接口(DELTE my_index/_mapping/my_type)

- 索引别名接口(_aliases)

- 更新索引设置接口(PUT my_index/_settings)

- 获取索引设置接口(GET my_index/_settings)

- 分析接口(_analyze): 分析某个字段是如何建立索引的

- 建立索引模版接口(_template): 为索引建立模版,以后新创建的索引都可以按照这个模版进行初始化

- 预热接口(_warmer): 某些查询可以事先预热,这样预热后的数据存放在内存中,增加后续查询效率

- 状态接口(_status): 索引状态

- 批量索引状态接口(_stats): 批量查询索引状态

- 分片信息接口(_segments): 提供分片信息级别的信息

- 索引恢复接口(_recovery): 进行索引恢复操作

- 清除缓存接口(_cache/clear): 清除所有的缓存

- 输出接口(_flush)

- 刷新接口(_refresh)

- 优化接口(_optimize): 对索引进行优化

- 升级接口(_upgrade): 这里的升级指的是把索引升级到lucence的最新格式

查看类API

- 查看别名接口(_cat/aliases): 查看索引别名

- 查看分配资源接口(_cat/allocation)

- 查看文档个数接口(_cat/count)

- 查看字段分配情况接口(_cat/fielddata)

- 查看健康状态接口(_cat/health)

- 查看索引信息接口(_cat/indices)

- 查看master信息接口(_cat/master)

- 查看nodes信息接口(_cat/nodes)

- 查看正在挂起的任务接口(_cat/pending_tasks)

- 查看插件接口(_cat/plugins)

- 查看修复状态接口(_cat/recovery)

- 查看线城池接口(_cat/thread_pool)

- 查看分片信息接口(_cat/shards)

- 查看lucence的段信息接口(_cat/segments)

集群类API

- 查看集群健康状态接口(_cluster/health)

- 查看集群状况接口(_cluster/state)

- 查看集群统计信息接口(_cluster/stats)

- 查看集群挂起的任务接口(_cluster/pending_tasks)

- 集群重新路由操作(_cluster/reroute)

- 更新集群设置(_cluster/settings)

- 节点状态(_nodes/stats)

- 节点信息(_nodes)

- 节点的热线程(_nodes/hot_threads)

- 关闭节点(/nodes/_master/_shutdown)

官方文档参考:Cluster APIS 。 尽在:https://www.elastic.co/guide/en/elasticsearch/reference/current/index.html

Kafka topic 常用命令介绍

空心菜 发表了文章 0 个评论 4445 次浏览 2016-10-26 22:47

本文主要记录平时kafka topic命令常使用的命令集,包括listTopic,createTopic,deleteTopic和describeTopic和alertTopic等,我这里是基于kafka 0.8.1.1版本,具体情况如下所示。

一、 describe topic 显示topic详细信息

# ./kafka-topics.sh --describe --zookeeper localhost:21811. 如上面可见,如果指定了--topic就是只显示给定topic的信息,否则显示所有topic的详细信息。

Topic:mobTopic PartitionCount:4 ReplicationFactor:1 Configs:

Topic: mobTopic Partition: 0 Leader: 0 Replicas: 0 Isr: 0

Topic: mobTopic Partition: 1 Leader: 1 Replicas: 1 Isr: 1

Topic: mobTopic Partition: 2 Leader: 2 Replicas: 2 Isr: 2

Topic: mobTopic Partition: 3 Leader: 0 Replicas: 0 Isr: 0

Topic:serverTopic PartitionCount:4 ReplicationFactor:1 Configs:

Topic: serverTopic Partition: 0 Leader: 2 Replicas: 2 Isr: 2

Topic: serverjsTopic Partition: 1 Leader: 0 Replicas: 0 Isr: 0

Topic: serverjsTopic Partition: 2 Leader: 1 Replicas: 1 Isr: 1

Topic: serverjsTopic Partition: 3 Leader: 2 Replicas: 2 Isr: 2

Topic:bugTopic PartitionCount:4 ReplicationFactor:1 Configs:

Topic: bugTopic Partition: 0 Leader: 1 Replicas: 1 Isr: 1

Topic: bugTopic Partition: 1 Leader: 2 Replicas: 2 Isr: 2

Topic: bugTopic Partition: 2 Leader: 0 Replicas: 0 Isr: 0

Topic: bugTopic Partition: 3 Leader: 1 Replicas: 1 Isr: 1

2. 如果指定了under-replicated-partitions,那么就显示那些副本数量不足的分区(ISR size < AR.size)

3. 如果指定了unavailable-partitions,那么就显示那些leader副本已不可用的分区

4. 从zookeeper上获取当前所有可用的broker

5. 遍历每个要describe的topic,

6. 获取这个topic的分区副本分配信息,若该信息不存在说明topic不存在

7. 否则将分配信息按照分区号进行排序

10. 如果没有指定步骤2中的参数也没有指定步骤3中的参数,那么显示分区数信息、副本系数信息以及配置信息

11. 默认情况下还会显示各个分区的信息

12. 从zookeeper中获取每个分区的ISR、Leader、AR信息并显示

二、create topic 创建topic

# kafka-topics.sh --zookeeper localhost:2181 --create --topic mobTopic --replication-factor 1 --partitions 4

- 从命令行中获取要创建的topic名称

- 解析命令行指定的topic配置(如果存在的话),配置都是x=a的格式

- 若指定了replica-assignment参数表明用户想要自己分配分区副本与broker的映射——通常都不这么做,如果不提供该参数Kafka帮你做这件事情

- 检查必要的参数是否已指定,包括:zookeeper, replication-factor,partition和topic

- 获取/brokers/ids下所有broker并按照broker id进行升序排序

- 在broker上分配各个分区的副本映射 (没有指定replica-assignment参数,这也是默认的情况)

- 检查topic名字合法性、自定义配置的合法性,并且要保证每个分区都必须有相同的副本数

- 若zookeeper上已有对应的路径存在,直接抛出异常表示该topic已经存在

- 确保某个分区的多个副本不会被分配到同一个broker

- 若提供了自定义的配置,更新zookeeper的/config/topics/[topic]节点的数据

- 创建/brokers/topics/[topic]节点,并将分区副本分配映射数据写入该节点

三、delete topic 删除topic

# ./kafka-topics.sh --zookeeper locahost:2181 --delete --topic mobTopic

- 获取待删除的topic,如果没有指定--topic就是删除所有的topic

- 对于每个要删除的topic,在zookeeper上的/admin/delete_topics下创建对应的子节点。kafka目前的删除topic逻辑只是在Zookeeper上标记而已,会有专门的线程负责监听该路径下的变更并负责更新zookeeper上其他节点上的数据,但底层的日志文件目前还是需要手动删除。

四、alert 修改topic的partion

# ./kafka-topics.sh --zookeeper localhost:2181 --alter --topic mobTopic --partitions 10减少目前kakfa应该是不支持.

Druid任务分配策略配置详解

Geek小A 发表了文章 2 个评论 5066 次浏览 2016-10-21 14:20

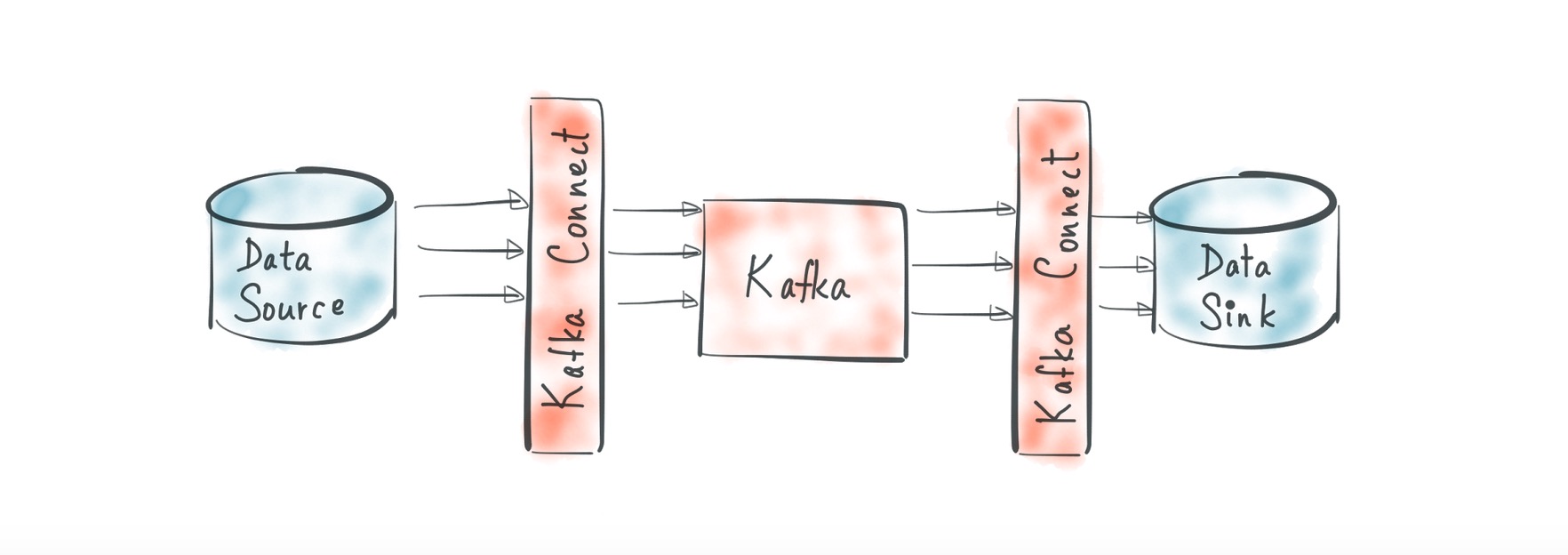

在说任务配置策略之前,先给大家看一下druid任务处理的大概架构图

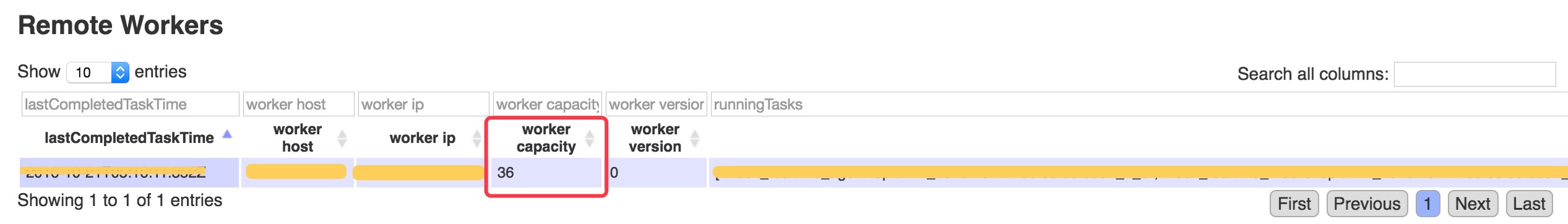

如上图可以看出overlord节点如何将任务分配到middlemanager节点进行处理,如果在架构中有多个middlemanager节点,那任务将怎么分配呢,分配的测试是什么?

默认策略是fillCapacity, 意思是当一个MiddleManager的worker capacity满了的时候,再有任务到来时,才会分配给另外的MiddleManager节点。

补充: middlemanager的capacity意思是,能容纳任务的数量,通过修改middleManager节点下的 runtime.properties配置文件里的druid.worker.capacity属性配置。

那么,除了这个策略,还有其他策略吗?另外,这个策略如何修改呢? 除了这个策略,还有fillCapacityWithAffinity, equalDistribution and javascript策略,那么策略如何修改呢?

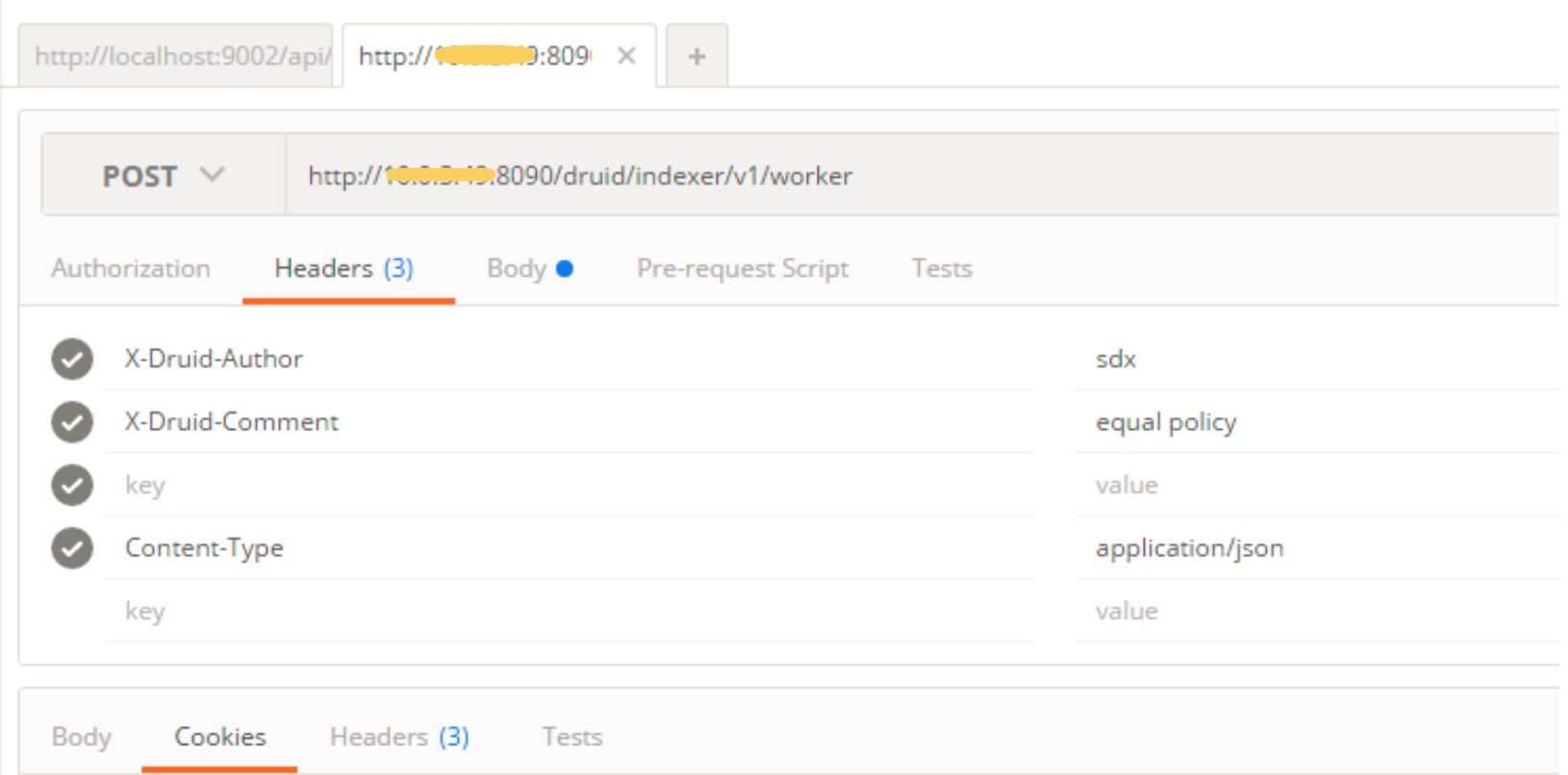

通过向Overlord节点发送个一个HTTP请求来修改,实质上是修改保存druid元数据的数据库,即 MetadataStorage,修改步骤如下:

http://10.1.3.9:8090/druid/indexer/v1/worker(http://: /druid/indexer/v1/worke

X-Druid-Author sdx(修改配置的作者,可以随意写) X-Druid-Comment equal policy(修改配置的注释,可以随意写) Content-Type application/json

http://10.1.3.9:8090/druid/indexer/v1/worker(http://: /druid/indexer/v1/worker)

{

"selectStrategy": {

"type": "equalDistribution" }

}

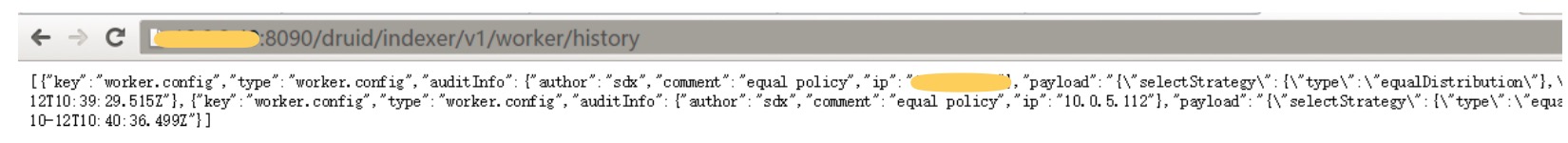

通过访问http://10.1.3.9:8090/druid/indexer/v1/worker/history查看配置是否成功

或者通过查看MetadataStorage的druid_conifg和druid_audit表查看是否配置成功

注意: linux上通过如下指令配置:

curl -XPOST -H 'X-Druid-Author: lucky' -H 'X-Druid-Comment: lucky' -H 'Content-Type: application/json' http://10.1.3.9:8090/druid/indexer/v1/worker -d '{ "selectStrategy": { "type": "equalDistribution" } }'更多内容请参考官网:http://druid.io/docs/0.9.1.1/configuration/indexing-service.html。